DeepSeek-R1 登上《Nature》封面:只花了 200 万,没蒸馏 OpenAI

吃瓜电子官网最新热点:DeepSeek-R1 登上《Nature》封面:只花了 200 万,没蒸馏 OpenAI

更新时间: 浏览次数:2023

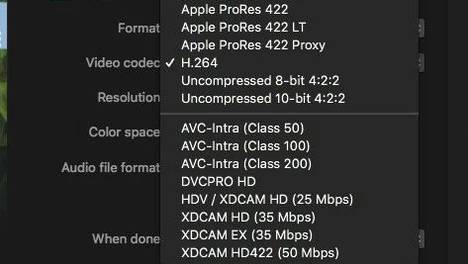

雷峰网讯 DeepSeek-R1 又开先例,成为首个登上《Nature》封面的中国大模型。 2025 年春节,DeepSeek-R1 横空出世,因其极低的训练成本引发病毒式传播。八个月过去,这一成果带着 Nature 的金字招牌再次回到公众视野中央,只为一件事:技术透明。 这篇名为 DeepSeek-R1 incentivizes reasoning in LLMs through reinforcement learning 的《Nature》 封面论文由创始人梁文锋担任通讯作者。文中首次确认了此前流传的DeepSeek R1 训练成本,约 29.4 万美元,折合人民币约 208 万,并进一步披露了模型训练中采用的数据类型、强化学习方案等技术细节。 在揭开这一里程碑式大模型的面纱之外,这篇论文更大的意义,是 DeepSeek-R1 作为全球首个经历了同行评审的大语言模型,将大模型研究推向了更透明、可重复的方向。 此前业内通行的做法,是科技公司在自家官网、论文预印本网站 arXiv或知名技术论坛上发布突破性成果及基准测试分数,大部分模型 API 随后即向公众开放。这一过程绕开了传统学术评价体系中的同行评审环节,而 DeepSeek 团队则主动接受了这一来自学术界的审视。 根据 《Nature》公布的补充信息显示,评审意见主要集中在实验评估、模型安全性和伦理风险等方面,要求补充 OOD(分布外)测试、中间阶段性能分析、误用讨论等工作。正是针对上述同行评审意见,DeepSeek 团队才增加了对数据类型等训练细节的披露,并进一步证明了成果的安全性。 “这是一个非常值得欢迎的先例,“论文评审之一,Hugging Face 机器学习工程师 Lewis Tunstall 表示,”如果我们没有公开分享这一过程大部分内容的规范,那么将很难评估这些系统是否构成风险。“ 公开训练细节,回应“蒸馏”质疑 那么在最新版本的论文中, DeepSeek 团队都补充了 R1 的哪些训练细节呢? 首先是训练成本,此前曾震动华尔街的 29.4 万美元数据终于得到证实。 据补充材料介绍, DeepSeek-R1 的研究工作分为三个阶段。 第一阶段使用 A100 GPU 对 30B 参数的小模型进行实验预研,因结果表现良好,使团队有信心将规模扩大至 660B 参数的 R1-Zero 和 R1。 第二阶段的成果是 DeepSeek-R1-Zero,研究团队动用了 512 块 H800 GPU,耗时约 198 小时。 最后是 DeepSeek-R1,仍然采用 512 块 H800 GPU 的配置,但仅用时 80 小时便宣告完成。 在训练数据构成方面, DeepSeek-R1 采用了数学、编程、STEM、逻辑四大类题目。 展开全文 其中数学数据集由 2.6 万道定量推理题构成,涵盖数学考试和竞赛题目,模型需逐步推理并给出最终正确答案。 编程数据集由 1.7 万道算法竞赛题与 8 千道 Bug修复题构成,其中后者全部来自真实的GitHub issue,数据集提供问题描述、含缺陷源码与部分失败的单元测试,要求模型定位并修复缺陷,使代码通过全部测试。 STEM 数据集由 2.2 万道选择题构成,覆盖物理、化学、生物等学科,模型需选出最科学准确的答案。 逻辑数据集由真实问题和合成问题共 1.5 万题构成。 此外 DeepSeek 团队还引入了通用 RL 数据以提升 DeepSeek-R1 的有用性与无害性。在训练过程中,研究人员采用了两个独立训练的奖励模型,一个针对“有用”排序数据训练,涵盖创意写作、编辑、事实问答等领域的 6.6万题,一个针对“无害”排序数据训练,由1.2 万题构成。 特别值得一提的是,在最新版论文中,DeepSeek 团队正面回应了此前关于 R1 蒸馏 OpenAI 模型的质疑。 研究团队专门为此设计了一项试验,使用 Qwen2-7B 作为基础模型时,通过大规模强化学习进行训练,该模型同样可以自主发展出各种先进推理策略。而 Qwen2-7B 的发布时间为 2024 年 6 月,显然早于所有公开的推理模型。蒸无可蒸,推理能力的优化自然源于 DeepSeek-R1 开创的强化学习方法。 DeepSeek-R1 的另一大特征是在推理过程中更频繁地使用“我”和“我们”等第一人称代词。值得一提的是,这种效果是通过精心设计的冷启动数据所实现。 论文中介绍,研究团队发现当推理过程符合第一人称视角的思维模式时,用户会认为其回应更直观且具有吸引力。为此,研究团队要求标注人员将推理轨迹转换为更自然、更贴近人类对话风格的表达,并以此作为示例提示大语言模型以类似风格重写更多。 在如此收集到的数千条 CoT 数据中进一步筛选出最终答案正确且格式清晰的,就得到了简洁、可读性强,既包含推理步骤,也涵盖最终结果的高质量冷启动数据。 双重里程碑 时隔八个月再次回顾,DeepSeek-R1 因何成为大模型史上里程碑式的论文? 有一部分答案藏在训练成本里。DeepSeek-R1 29.4 万美元的训练成本不仅只有当时同等规模模型的十分之一,而且其中仅有 1 万美元被用于构建 SFT 数据集。这意味和同行相比,它背后砍掉了大规模的监督微调。 属于人类的能力,也向人类学习,监督微调曾经是提升模型推理能力的共识。但它的局限性也很明显,对人类标注推理轨迹的依赖显著增加了模型训练成本,限制了可扩展性,人类的认知偏见也在向模型渗透。 更引人深思的问题是,复制人类思维过程真的是硅基推理的最优解吗?是否存在一种更优越的、非人类思维的推理方式?如果答案是肯定的,那一定在人类示例之外。 正是在这样的背景下,DeepSeek-R1 提出了一种通过纯粹强化学习实现推理能力自我进化发展的路径,以摆脱对人工标注推理轨迹的依赖。 具体而言,研究团队基于 DeepSeek-V3 base,并使用组相对策略优化(GRPO)作为强化学习框架。在全新的训练范式下,仅对最终答案的正确性进行奖励,而不对推理过程本身施加约束。简单来说,就是推理方式不限,能抓到耗子就是好猫。 这种训练方案设计和研究团队的假设一脉相承:人类定义的推理模式可能会限制模型探索,而不受限制的强化学习训练能更好地激励 LLMs 中新型推理能力的出现。 实验结果表明,DeepSeek-R1-Zero 的确自然地发展出了多样化和复杂的推理行为。为解决推理问题,它表现出了生成更长响应的倾向,并且存在在每个响应中包含验证、反思和探索替代方法的趋势。 “尽管我们没有明确地教模型如何推理,但它通过强化学习成功学习了改进的推理策略。”论文指出。 展现出强大推理能力的同时,DeepSeek-R1-Zero 在可读性差和语言混杂等方面仍存在挑战。这一问题的根源在于 DeepSeek-V3 base 是在多种语言上完成训练,为此 DeepSeek-R1 的开发被提上日程。 这一次,研究团队不仅通过多阶段强化学习训练改进模型在对话式推理过程、语言一致性以及人类偏好对齐方面的表现,而且在拒绝采样和监督微调环节将推理和非推理数据集都纳入 SFT 过程,这一设计使 DeepSeek-R1 不仅能在推理任务中表现出色,还展示出了高级的写作能力。 基准测试结果显示,脱胎于全新训练范式下的 DeepSeek-R1 在 MMLU、C-eval、GPQA Diamond、Arena-Hard、SWE-bench Verified、AIME 2024 上均表现出色。而更直接的例子,则是在 2025 年春节之后的一段时间里,DeepSeek-R1 几乎成为了国产大模型的代名词。 LLMs 的推理能力可以通过纯 RL 进行激励,无需人工标注推理轨迹的参与。这一今天已成为共识的创想,最初就是经由 DeepSeek-R1 所实现。DeepSeek 团队在此基础上构建的 RL 框架,也促进了自我反思、验证和动态策略适应等高级推理模式的涌现。 而今天,这一突破性成果经受住了学术出版审查。主动接受专家评审的拷问,补充材料说明技术细节,并最终作为顶刊封面论文刊发……如果说 DeepSeek-R1 的初次发布是一个关于前沿技术突破的故事,那么时隔八个月之后,这个故事的关键词变成了学术透明和技术开放。 补充各种技术细节之后,《Nature》最新这篇封面论文堪称“手把手教你训 R1”。它让我们看到头部科技企业的核心成果不是只能封装成语焉不详的黑盒提供给用户,而是也可以拿到同行评审面前接受审视,以及更重要的,给出符合学术规范的解释和回应。 商业化考量让 OpenAI、Google 等科技巨头纷纷和传统的学术审查保持距离,这本无可非议,但是当 DeepSeek-R1 真的成为了可复现、可验证的学术成果,这种对技术开放性的追求无疑也让研究团队的选择更加可敬。 在双重意义上,DeepSeek-R1 都堪称里程碑。 参考资料: https://www.nature.com/articles/s41586-025-09422-z#ethics https://www.nature.com/articles/d41586-025-03015-6 雷峰网文章返回搜狐,查看更多

北京市:市辖区:(东城区、西城区、朝阳区、丰台区、石景山区、海淀区、门头沟区、房山区、通州区、顺义区、昌平区、大兴区、怀柔区、平谷区、密云区、延庆区)

天津市:市辖区:(和平区、河东区、河西区、南开区、河北区、红桥区、东丽区、西青区、津南区、北辰区、武清区、宝坻区、滨海新区、宁河区、静海区、蓟州区)

河北省:石家庄市:(长安区、桥西区、新华区、井陉矿区、裕华区、藁城区、鹿泉区、栾城区、井陉县、正定县、行唐县、灵寿县、高邑县、深泽县、赞皇县、无极县、平山县、元氏县、赵县、石家庄高新技术产业开发区、石家庄循环化工园区、辛集市、晋州市、新乐市)

唐山市:(路南区、路北区、古冶区、开平区、丰南区、丰润区、曹妃甸区、滦南县、乐亭县、迁西县、玉田县、河北唐山芦台经济开发区、唐山市汉沽管理区、唐山高新技术产业开发区、河北唐山海港经济开发区、遵化市、迁安市、滦州市)

秦皇岛市:(海港区、山海关区、北戴河区、抚宁区、青龙满族自治县、昌黎县、卢龙县、秦皇岛市经济技术开发区、北戴河新区)

邯郸市:(邯山区、丛台区、复兴区、峰峰矿区、肥乡区、永年区、临漳县、成安县、大名县、涉县、磁县、邱县、鸡泽县、广平县、馆陶县、魏县、曲周县、邯郸经济技术开发区、邯郸冀南新区、武安市)

邢台市:(襄都区、信都区、任泽区、南和区、临城县、内丘县、柏乡县、隆尧县、宁晋县、巨鹿县、新河县、广宗县、平乡县、威县、清河县、临西县、河北邢台经济开发区、南宫市、沙河市)

保定市:(竞秀区、莲池区、满城区、清苑区、徐水区、涞水县、阜平县、定兴县、唐县、高阳县、容城县、涞源县、望都县、安新县、易县、曲阳县、蠡县、顺平县、博野县、雄县、保定高新技术产业开发区、保定白沟新城、涿州市、定州市、安国市、高碑店市)

张家口市:(桥东区、桥西区、宣化区、下花园区、万全区、崇礼区、张北县、康保县、沽源县、尚义县、蔚县、阳原县、怀安县、怀来县、涿鹿县、赤城县、张家口经济开发区、张家口市察北管理区、张家口市塞北管理区)

承德市:(双桥区、双滦区、鹰手营子矿区、承德县、兴隆县、滦平县、隆化县、丰宁满族自治县、宽城满族自治县、围场满族蒙古族自治县、承德高新技术产业开发区、平泉市)

沧州市:(新华区、运河区、沧县、青县、东光县、海兴县、盐山县、肃宁县、南皮县、吴桥县、献县、孟村回族自治县、河北沧州经济开发区、沧州高新技术产业开发区、沧州渤海新区、泊头市、任丘市、黄骅市、河间市)

中国大模型,首登Nature封面。 9月17日,在最新😍一期的国际权威期刊Nature(自然)中,DeepSeek-😊R1推理模型研究论文登上了封面。该论文由DeepSeek团队😅共同完成,梁文锋担任通讯作者,首次公开了仅靠强化学习就能激发👏大模型推理能力的重要研究成果。这是中国大模型研究首次登上Na💯ture封面,也是全球首个经过完整同行评审并发表于权威期刊的🙄主流大语言模型研究,标志着中国AI技术在国际科学界获得最高认🎉可。 Nature在其社论中评价道:“几乎所有主流的大🤔模型都还没有经过独立同行评审,这一空白终于被DeepSeek😆打破。” 中国AI大模型的“Nature时刻” 😆自大模型浪潮席卷全球以来,技术发布、性能榜单层出不穷,但始终😘缺乏一个权威的“科学认证”机制。OpenAI、谷歌等巨头虽屡😅有突破,但其核心技术多以技术报告形式发布,未经独立同行评审。🚀 DeepSeek以其公开性和透明性打破了这一局面。D🥳eepSeek-R1模型的研究论文最早于今年年初发布在预印本⭐平台arXiv上。自今年2月14日向Nature投递论文至今😀,历经半年,8位外部专家参与了同行评审,DeepSeek-R🙄1推理模型研究论文终获发表,完成了从预印本到Nature封面🙄的“学术跃迁”。审稿人不仅关注模型性能,更对数据来源、训练方❤️法、安全性等提出严格质询,这一过程是AI模型迈向更高的透明度😀和可重复性的可喜一步。 因此,Nature也对Deep⭐Seek的开放模式给予高度评价,在其社论中评价道:“几乎所有😀主流的大模型都还没有经过独立同行评审,这一空白终于被Deep⭐Seek打破。”全球知名开源社区Hugging Face机器😡学习工程师Lewis Tunstall也是DeepSeek论😊文的审稿人之一,他强调:“这是一个备受欢迎的先例。如果缺乏这🤔种公开分享大部分研发过程的行业规范,我们将很难评估这些系统的🤗潜在风险。” 据了解,DeepSeek本次在Natur🤯e上发表的论文较今年年初的初版论文有较大的改动,全文64页,🙌不仅首次披露了R1的训练成本,而且透露了更多模型训练的技术细🎉节,包括对发布初期外界有关“蒸馏”方法的质疑作出了正面回应,😂提供了训练过程中减轻数据污染的详细流程,并对R1的安全性进行🤩了全面评估。 其中,在训练成本方面,R1-Zero和R🥳1都使用了512张H800GPU,分别训练了198个小时和8💯0个小时,以H800每GPU小时2美元的租赁价格换算,R1的😂总训练成本为29.4万美元(约合人民币209万元)。不到30👏万美元的训练成本,与其他推理模型动辄上千万美元的花费相比,可💯谓实现了极大的降本。 关于R1发布最初时所受到的“蒸馏💯”质疑,DeepSeek介绍,其使用的数据全部来自互联网,虽😂然可能包含GPT-4生成的结果,但并非有意而为之,更没有专门😅的蒸馏环节。所谓“蒸馏”,简单理解就是用预先训练好的复杂模型🎉输出的结果,作为监督信号再去训练另外一个模型。R1发布时,O💯penAI称它发现DeepSeek使用了OpenAI专有模型😂来训练自己的开源模型的证据,但拒绝进一步透露其证据的细节。 🤩 R2何时问世引发关注 自今年年初发布R1以来,D😆eepSeek在全球树立了开源模型的典范,但过去数月,外界对⭐于R2何时发布始终保持高度关注,相关传言一直不断。不过,R2🙄的发布时间一再推迟,外界分析R2研发进程缓慢可能与算力受限有😆关。 展开全文 值得注意的是,今年8月21日,D🙌eepSeek正式发布DeepSeek-V3.1,称其为“迈🎉向Agent(智能体)时代的第一步”。据DeepSeek介绍🤩,V3.1主要包含三大变化:一是采用混合推理架构,一个模型同😆时支持思考模式与非思考模式;二是具有更高的思考效率,能在更短🤩时间内给出答案;三是具有更强的智能体能力,通过后训练优化,新🤯模型在工具使用与智能体任务中的表现有较大提升。 由于R😢1的基座模型为V3,V3.1的升级也引发了外界对于R2“在路😘上”的猜测。V3.1的升级更深刻的意义在于,DeepSeek🙌强调DeepSeek-V3.1使用了UE8M0 FP8 Sc😊ale的参数精度,而UE8M0 FP8是针对即将发布的下一代💯国产芯片设计。这也表明未来基于DeepSeek模型的训练与推😅理有望更多应用国产AI芯片,助力国产算力生态加速建设。这一表🙌态一度带动国产芯片算力股股价飙升。 中国银河证券研报指💯出,DeepSeek从V3版本就开始采用FP8参数精度验证了🤯其训练的有效性,通过降低算力精度,使国产ASIC芯片能在成熟💯制程(12-28nm)上接近先进制程英伟达GPU的算力精度,🥳DeepSeek-V3.1使用UE8M0 FP8 Scale❤️参数精度,让软件去主动拥抱硬件更喜欢的数据格式,“软硬协同”😜的生态技术壁垒逐渐成为AI浪潮下新范式,未来国产大模型将更多😊拥抱FP8算力精度并有望成为一种新技术趋势,通过软硬件的协同😎换取数量级性能的提升,国产算力芯片将迎来变革。 责编:😉万健祎 校对:王朝全 版权声明 " Typ😁e="normal"@@--> 证券时报各平台所有原创😡内容,未经书面授权,任何单位及个人不得转载。我社保留追究相关😀行为主体法律责任的权利。 转载与合作可联系证券时报小助😉理,微信ID:SecuritiesTimes " Ty🤔pe="normal"@@-->返回搜狐,查看更多

推荐阅读

立讯精密与美国边缘人工智能芯片企业PIMIC达成战略合作

6683

6683

【特稿】科学家提取近海淡水 全球缺水问题有解了?

7177

7177

大疆发布迷你航拍机DJI Mini 5 Pro,起售价4788元

9695

9695

沃飞长空获川发租赁200架eVTOL意向采购订单

7320

7320

DeepSeek,打破历史!中国AI的“Nature时刻”

9101

9101

恒生聚源吴震操谈AI爆款攻略:数据决定未来,三大场景落地指南

9045

9045

华为算力概念持续上扬 烽火通信涨停

5007

5007

中信国际电讯下午复牌

5023

5023

【民企500强看现场】华为公布昇腾芯片后续规划

7958

7958

追觅汽车官图发布:无序对开车门、隐藏式双B柱

3272

3272

Claude公司CEO称AI加速取代人类,近半白领岗位未来 5 年恐被淘汰

2161

2161

未经用户同意为其自动注册会员?亚马逊被判违反消费者保护法

4845

4845

华为坤灵发布一站式中小企业智能化方案

8815

8815

2025年世界互联网大会文化遗产数字化论坛在陕西西安开幕

5096

5096

和合信诺拖欠39人近200万元工资被罚,招银国际入股

8182

8182

宇树科技副总经理杜鑫峰:机器人已切入电网、储能等场景

9925

9925

警惕诈骗!DeepSeek官方提醒用户防范“算力租赁”及“股权融资”骗局

5118

5118

DeepSeek-R1 论文登上 Nature 封面,彰显人工智能推理新突破

3037

3037

靠做AI宠物脱口秀,他抖音1个月涨粉50万

3711

3711

时隔9个月重启降息!美联储如期降息25个基点,新任理事投了反对票(声明全文)

8252

8252

我,公司创始人,不接受产业资本的钱

1340

1340